Погрешность и точность си

Погрешности средств измерений отражают несовершенство измерительного устройства и возникают вследствие многих причин, а именно: несовершенства конструкции, материалов и технологии изготовления, неудовлетворительного качества изготовления, погрешности градуировки и др.

Погрешность прибора характеризует отличие его показаний от истинного или действительного значения измеряемой величины. Погрешность преобразователя определяется отличием номинальной (т.е. приписываемой преобразователю) характеристики преобразования или коэффициента преобразования от их истинного значения.

Погрешность меры характеризует отличие номинального значения меры от истинного значения воспроизводимой ею величины. Для многозначной меры погрешность при данном показании определяется как разность между показанием и 1 действительным значением измеряемой величины. Номинальное значение меры — значение данной физической величины, обозначенное на мере (или на ее футляре). Это определение относится главным образом к однозначным мерам. Для многозначных мер и магазинов мер — это «показание меры», под которым подразумевают значение величины, воспроизводимой мерой, устанавливаемое по отсчету. Вариация показаний — наибольшая разность между показаниями, по- 1 лученными при многократно повторенных измерениях одной и той же величины.

Точность СИ— качество, отражающее близость к нулю его погрешности. Например, при погрешности прибора Д =10-4 (0,01%) точность — 104. Возникновение погрешности СИ объясняется рядом причин, в том числе приближенным рас- I четом характеристик, отличием параметров элементов и узлов прибора от требуемых расчетных значений, старением элементов и узлов, паразитными параметрами элементов, внутренними шумами, изменением влияющих величин и неинформативных параметров входного сигнала и др. Погрешности СИ оцениваются при его поверке. Поверка СИ — определение метрологической организацией погрешностей СИ и установление его пригодности к применению. Поскольку погрешность во времени может изменяться, поверку проводят с определенной периодичностью.

По способу выражения различают погрешности:

— абсолютная погрешность прибора — разность между показаниями прибора xп и истинным значением х измеряемой величины: А =хп — х.

— относительная погрешность прибора — отношение абсолютной погрешности прибора к истинному (действительному) значению измеряемой величины: А/х или в процентах 100дельта/x, где если х >>дельта, то вместо х с достаточной степенью точности можно использовать хП.

— приведенная погрешность прибора — отношение в процентах абсолютной погрешности прибора к нормирующему значению: Д = 100/xнорм .

В соответствии с ГОСТ 8.401—80 уормирующее значение хн принимается равным:

— большему из пределов измерений или большему из модулей пределов измерений для СИ с равномерной или степенной шкалой, если нулевая отметка находится на краю или вне диапазона измерений;

— арифметической сумме модулей пределов измерений, если нулевая отметка находится внутри диапазона измерений;

— установленному номинальному значению для СИ с установленным номинальным значением измеряемой величины;

— всей длине шкалы для приборов с существенно неравномерной шкалой, при этом абсолютные погрешности также выражают в единицах длины.

Во всех остальных случаях нормирующее значение устанавливается стандартами для соответствующих видов СИ.

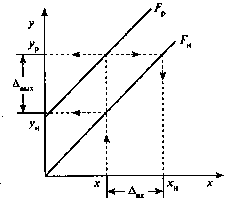

Для преобразователей определение абсолютных и относительных погрешностей несколько сложнее. Они определяются по входу Двх и выходу Двых и характеризуют отличие реальной характеристики преобразования у = F (х) от номинальной ун= FH(x) .

Рис. Формирование погрешности преобразования

Для оценки погрешности по выходу находят значения у и ун при заданной величине х. Тогда Двых = у — ун , а относительная погрешность А = Двых/ур. По входу Двх = хн — х; где хн = FH-](y ) определяется через значение ур и функцию, обратную FH , т.е. хн — такое значение х, которое при номинальной характеристике дало бы на входе значение у р А = Двх /х — относительная погрешность.

Уже отмечалось, что в зависимости от условий применения СИ погрешности делятся на основную (при нормальных условиях) и дополнительную (при рабочих условиях).

В зависимости от поведения измеряемой величины во времени различают статическую и динамическую погрешности, а также погрешность в динамическом режиме. Статическая погрешность СИ (Аст) — погрешность СИ, используемого для измерения постоянной величины (например, амплитуды периодического сигнала). Погрешность в динамическом режиме (Адин р) — погрешность СИ, используемого для измерения переменной во времени величины.